티스토리 뷰

개요

이번 Microsoft Build 2023 행사에서 있었던 Andrej Karpathy의 State of GPT 강의(?) 유튜브 영상을 보고 새로이 배우거나 인상적이었던 깨달음을 메모해둔다.

유튜브 링크: https://youtu.be/bZQun8Y4L2A

메모들

Pretraining이 가장 자원을 많이 먹는 단계이다.

수 개월동안, 수 천개의 GPU를 사용하고 있다.

파라미터 개수가 전부가 아니다.

GPT-3의 파라미터 개수가 3배 가까이 많지만, 트레이닝에 사용한 개수는 LLaMA가 3배 이상 많다는 것에 주목하자

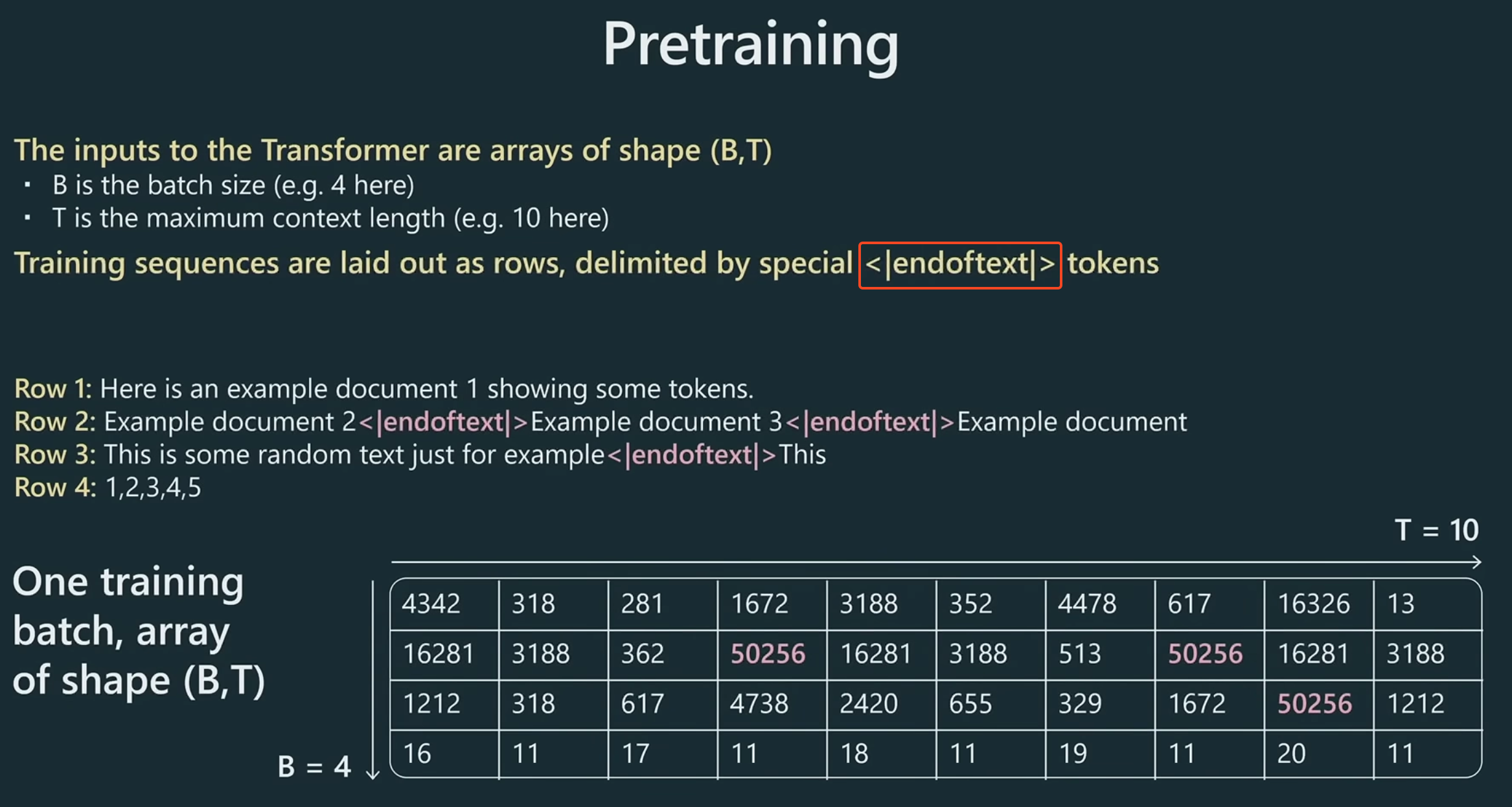

특수한 토큰 endoftext == 50256

하나의 트레이팅 토큰 묶음은 endoftext라는 특별히 정의한 토큰으로 구분한다.

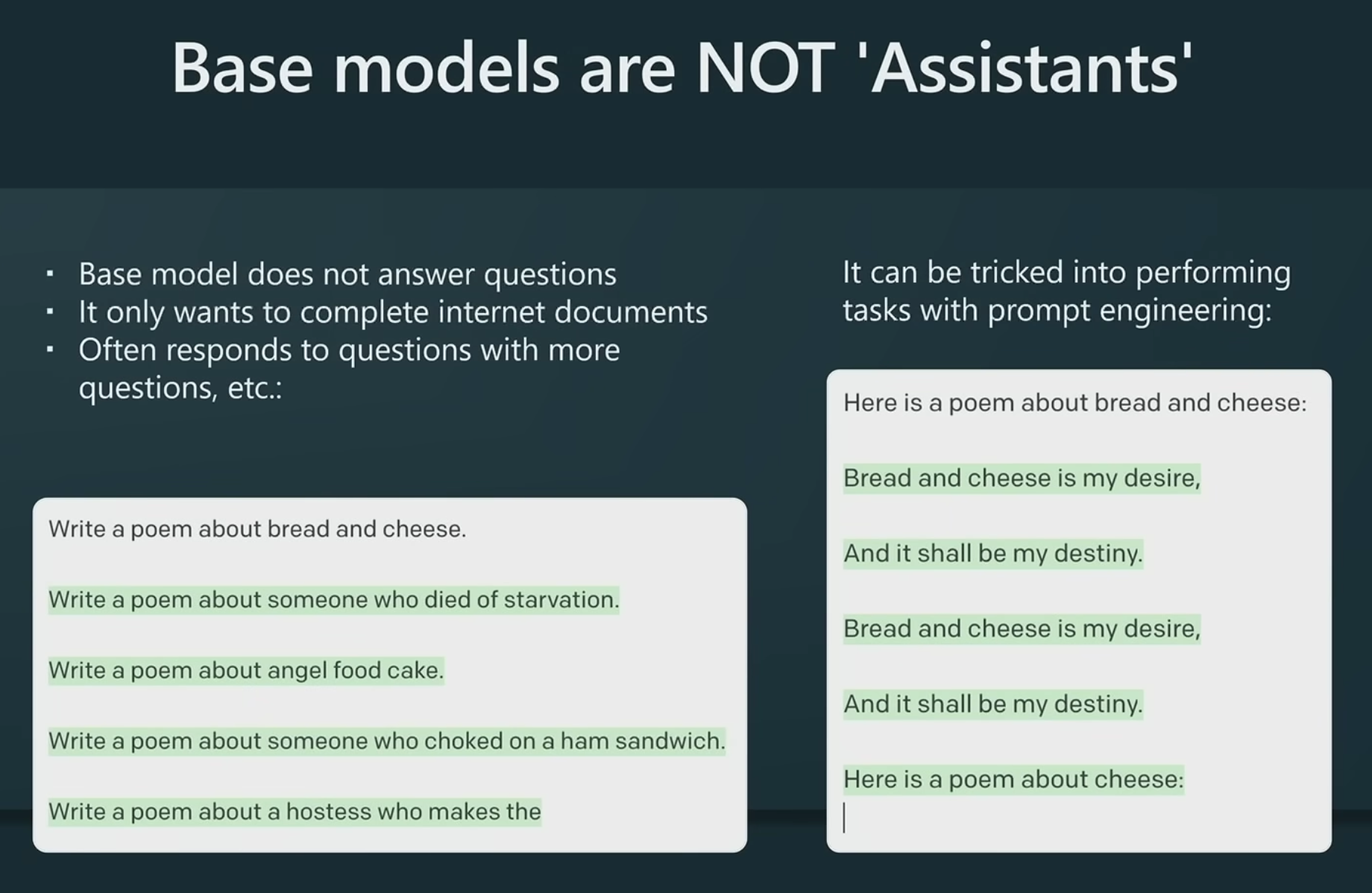

Base model은 Assistant가 아니다

Base model은 그저 인터넷 문서를 완성해주는 역할을 할 뿐이다. 그런데 이러한 모델에 prompt를 잘 쓰면 마치 답을 하는 것 처럼 쓸 수 있는 것이다. 그저 질문을 하는 것이 아니라, 여러 조건이나 상황, 입장에서의 문장을 완성하라고 하는 것이다.

Base Model은 3단계의 finetuning이 가능하다.

- Supervised Finetuning(SFT): 1~10만개의 prompt-response 쌍을 준비해서 파인튜닝

- Reward Modeling(RM): 10~100만개의 response에 대한 선호 점수값을 준비

- Reinforcement Learning(RL): 1~10만개의 prompt를 준비해서 1, 2를 기반으로 강화학습

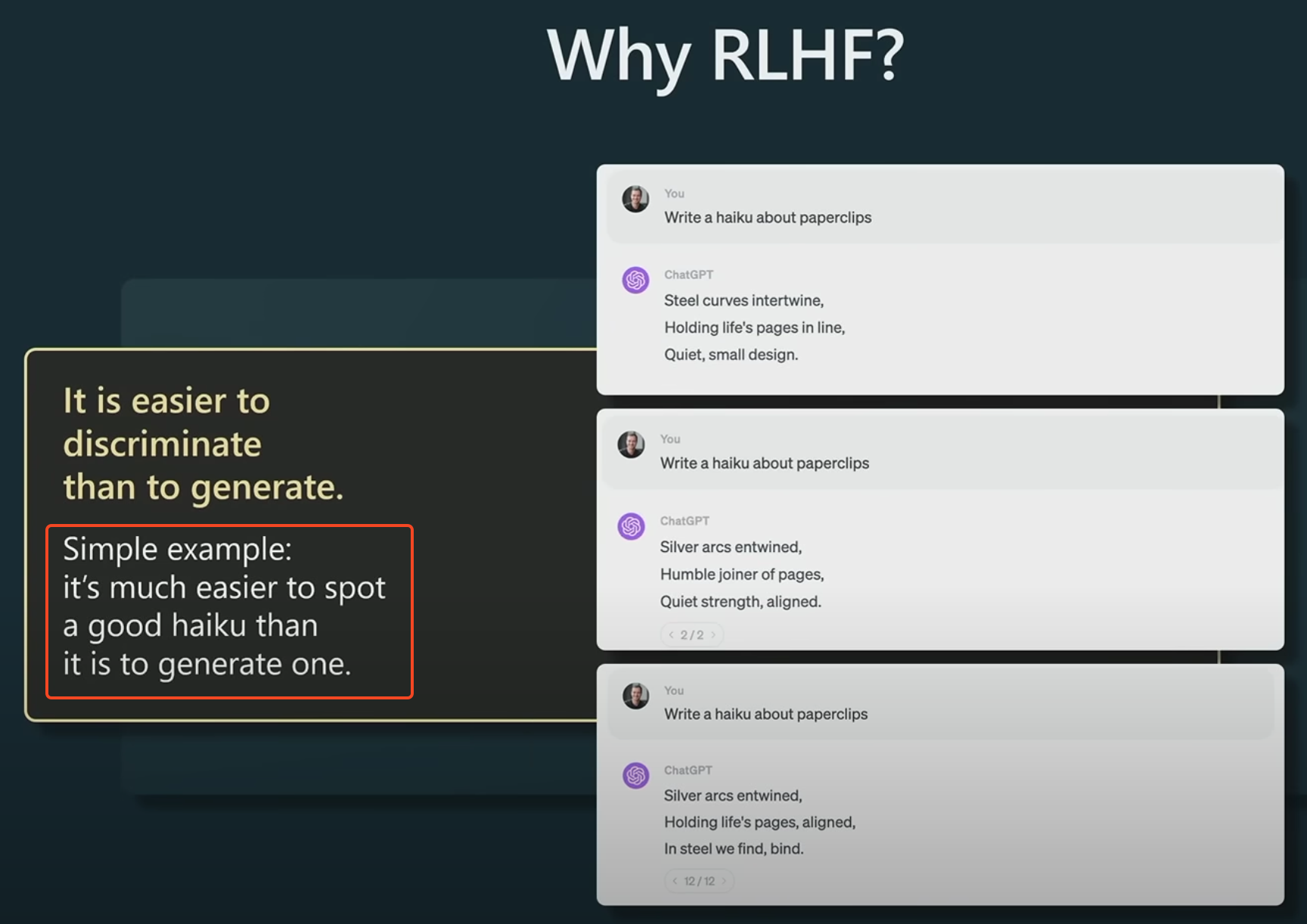

RLHF(Reinforcement Learning Human Feedback)

이게 잘 동작하는 이유가 명확한 정답은 없다. 아마도 무언가를 생성해내는 것 보다는 생성된 것들 중에서 무엇이 나은 지를 추려내는 것이 더 쉽기 때문이 아닐까 한다. RLHF는 창조적이거나 자연어 이해를 좀더 필요로 하는 분야에 유리하다

Base Model은 그 나름의 쓰일모와 가치가 있다

파인튜닝을 하지 않은 Base Model은 그다지 쓸모가 없다고 생각했었는데, 학습한 데이터의 가능성과 가치를 손상없이 보존하고 있다는 개념을 얻게 되었다. 이는 마치 디지털 카메라의 raw 포맷 이미지를 떠올리게 한다. 강의에서는 entropy를 보존하고 있다는 표현을 썼다.

토큰 하나만 틀려도 계속 엉뚱한 곳으로 간다

결국 Base Model은 다음, 그 다음 토큰을 써나가는 것이다. 자기가 맞는 말을 하는지 자체를 모른다. 그러니, prompt로 잘 가이드만 해줘도 바로잡아주는 데 도움이 된다. 잘 쓴거 맞니? 라고 물어주는 것 만으로 다음 생성해야 할 토큰들은 이미 만들어낸 토큰들과 다른 방향으로 써야 한다는 단서가 되는 것이다.

시스템1과 시스템2

대니얼 카너먼의 생각에 관한 생각에서 나오는 개념인 시스템1, 시스템2를 떠올려도 된다. 기본적으로 Base Model은 머리에 떠오르는 대로 주절주절 떠들어대는 시스템1인 것이다. 그런 녀석에게 제대로 집중해서, 합리와 논리를 따지는 시스템2를 쓰도록 하는 것이 프롬프트인 것이다. 다음은 예시다.

- 단계를 밟아서 차근히 문제를 풀어보자

- 단계를 밟아서 문제를 풀어보자. 이번 문제는 꼭 정답을 써야 해

과외 선생님이 된 것처럼 LLM의 마음을 다잡게 하거나, 집중해서 문제를 풀어야 하는 상황이라는 것을 인지시키는 것 만으로 더 나은 결과를 얻게 되는 것이다.

너는 천재야, 너는 바보야

아이큐 120 인 것처럼 대답하라고 하면 어떻게 될까? LLM이 가지고 있는 다양한 문장 생성중에서 그래도 똑똑하다고 생각되는 이들의 문장 생성에 가중치를 두고 문장을 생성할 것이다. 이것은 마치 LLM이 말 귀를 알아듣는 것처럼 느끼게 할 것이다. 하지만 아이큐 400이라고는 하지 말자. LLM은 그런 사례 데이터가 없거나, 극히 드물 것이다.

너는 수학 못한다는 걸 잊지마 - 라고 프롬프트를 줄 수 도 있다. 이 경우는 떠오르는 대로 말하지 말고 특정한 도구를 써서, 혹은 문제를 풀 수 있는 파이썬 코드를 짜서 답을 내게 만들어준다.

'generative-ai' 카테고리의 다른 글

| LLM 기반 챗봇으로 비공개 지식 소통하기 (0) | 2023.06.29 |

|---|---|

| 유튜브 정리: 샘 알트먼, 일리야 수츠케버 in 텔아비브 (0) | 2023.06.16 |

| ChatGPT는 로그도 알아서 설명해줘요 (0) | 2023.05.16 |

| GitHub Copilot Chat confidential rules (0) | 2023.05.16 |

| OpenAI API 사용해보기. feat gpt-cli (0) | 2023.05.13 |

- Total

- Today

- Yesterday

- 티스토리챌린지

- backend

- 체호프

- strange

- notion

- golang

- Gin

- Echo

- API

- 오블완

- agile

- 독서

- MCP

- websocket

- gocore

- claude code

- intellij

- github

- 잡학툰

- 영화

- 독서후기

- go

- 인텔리제이

- 클린 애자일

- solid

- clean agile

- bun

- OpenAI

- postgres

- ChatGPT

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | 31 |